公司名称: 长沙小番茄科技有限公司

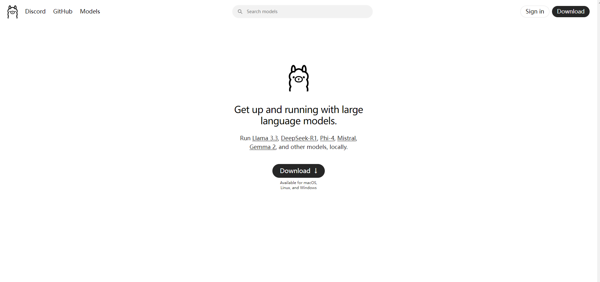

Ollama本地部署工具是一款用在本地部署和运行Ai模型的工具,软件可以帮助用户在本地环境的中轻松高效的部署和使用大型语言模型,Ollama本地部署工具客户端提供对多种先进的语言模型的支持,用户可以根据自己的需求选择适合的模型进行部署。

Ollama本地部署工具能够让用户在自己的环境中运行模型,不需要通过外部云端进行处理,提供了更高的灵活性和控制性,同时保证了数据安全性。

软件功能

本地高效推理:避免了因依赖云端服务而可能产生的网络延迟问题,实现快速响应。对于有大量数据处理需求或对实时性要求较高的场景,本地推理优势明显。

交互式对话体验:提供交互式命令行界面,用户可以像与聊天机器人对话一样与模型进行交互。支持流式输出,即模型在生成回答的过程中会逐字逐句显示,让用户能更快获取部分信息。

API 接口调用:Ollama 提供 RESTful API 接口,方便开发者将其集成到自己的应用程序中。开发者可以通过发送 HTTP 请求来调用模型,实现如智能客服、内容生成等功能,拓展了模型的应用场景。

资源优化配置:能够根据本地硬件资源的情况,对模型的运行进行优化配置。例如,自动调整模型的内存使用、线程数等参数,以充分发挥硬件性能,同时避免资源过度占用导致系统卡顿。

性能监控:可实时监控模型运行时的性能指标,如 CPU 和 GPU 的使用率、内存占用情况等。用户可以通过这些指标了解模型的运行状态,及时发现潜在问题并进行调整。

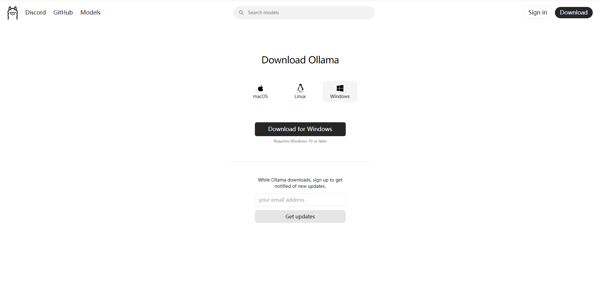

安全下载

安全下载